¿Qué es la Evaluación de Procesos?

La Evaluación de Procesos (EP) en la Plataforma se define como un análisis sistemático de la operación del programa de graduación, cuyo objetivo es identificar cómo sus procesos y actividades contribuyen al logro de los resultados definidos en el diseño. Esta evaluación permite detectar cuellos de botella y buenas prácticas que pueden haber impactado la aplicación de dichos procesos y actividades, con el fin de ofrecer recomendaciones y áreas de oportunidad para su mejoramiento (Mendoza, Moreno-Sánchez y Maldonado, 2015). La implementación de la EP se realiza de manera paralela a la ejecución del programa y se enfoca en aquellos procesos que inciden directamente en el cumplimiento de los objetivos o la finalidad del programa.

Dada la naturaleza del objeto de análisis, es una evaluación que emplea principalmente información cualitativa proveniente, por ejemplo, de entrevistas estructuradas dirigidas a profesionales de las entidades (responsable del programa e implementadoras) y a participantes. Puede emplear también información cuantitativa, resultante por ejemplo de encuestas estructuradas que buscan estimar indicadores numéricos. Estos indicadores pueden ser de eficacia o (para determinar si la ejecución de los procesos contribuye al logro de los objetivos), o de calidad (para identificar percepciones sobre el desempeño de las entidades implementadoras y de satisfacción de los beneficiarios del programa).

¿Cómo se hace la Evaluación de Procesos?

1. Construcción de la hipótesis

Orienta el ejercicio de la evaluación. La hipótesis debe ser clara y debe guiar el planteamiento de los objetivos.

2. Planteamiento de los objetivos

3. Definición de los alcances

4. Desarrollo

Es el eje central de la evaluación y se realiza de manera paralela a la implementación de los programas de graduación.

Requiere la identificación de momentos clave en la implementación del programa de graduación, que pueden ser:

- El inicio del programa, cuándo es preciso recoger información de línea base o de contexto;

- El final del programa, cuando se recolecta información que permite determinar si los productos y resultados esperados corresponden con los alcanzados

- Momentos intermedios donde se distribuyan productos centrales para el logro de los objetivos del programa

Los resultados obtenidos son el insumo para la formulación de las recomendaciones de futuros escalonamientos y aplicaciones de los programas

4.1. Descripción detallada del programa

Se realiza para entender con detalle la operación y el funcionamiento del programa de graduación. Incluye cuatro aspectos:

- Análisis factual y contextual.

- Construcción de la cadena de valor.

- Construcción del mapa de actores e identificación de responsabilidades en la cadena de valor.

- Elaboración del cronograma detallado del programa.

4.2. Análisis de eficacia

Busca determinar si se lograron los objetivos planteados. Incluye tres actividades:

- Definir los indicadores.

- Estimar los indicadores.

- Analizar los indicadores.

Es preciso formular indicadores para cada subproceso sustantivo. Estos indicadores son, generalmente cuantitativos; sin embargo, los valores deben estar enmarcados y tener en cuenta los resultados obtenidos a partir de recolección de información cualitativa.

4.3. Análisis de calidad

Permite identificar el desempeño de las entidades implementadoras y conocer la opinión de los participantes.

Los indicadores de calidad de la Plataforma se definen para medir la utilidad, la oportunidad (momento adecuado), la suficiencia (cantidad necesaria), y la satisfacción de los insumos entregados y de las actividades desarrolladas en los diferentes procesos, desde la perspectiva de la oferta (entidades implementadoras) y de la demanda (participantes). Los indicadores pueden ser cuantitativos o cualitativos.

Incluye tres actividades:

- Definir los indicadores.

- Estimar los indicadores.

- Analizar los indicadores.

La información resultante de este análisis debe estar contextualizada y explicarse a partir de la triangulación de la información obtenida en otros pasos.

4.4. Análisis de factores externos

Este análisis pretende identificar de manera general y contextual diferentes factores externos (algunos de ellos no controlables), que puedan afectar el desarrollo de los procesos y de los resultados del programa de graduación. Este análisis pretende fortalecer la formulación de las recomendaciones que buscan contribuir en el perfeccionamiento del programa de graduación. Se esquematiza utilizando la cadena de valor en cada uno de los subprocesos.

4.5. Identificación de buenas prácticas y cuellos de botella

Busca identificar, describir y comprender a profundidad las buenas prácticas y los cuellos de botella que se presentaron durante la implementación del programa de graduación, analizando las causas y las consecuencias de cada uno.

Este análisis pretende fortalecer la formulación de las recomendaciones que buscan contribuir en el perfeccionamiento del programa de graduación. Se esquematiza utilizando la cadena de valor en cada uno de los subprocesos.

5. Formulación de conclusiones y recomendaciones

Busca ofrecer un concepto integral del programa y proponer líneas de planeación estratégica que permita tomar acciones correctivas a corto y mediano plazo.

¿Qué es la Evaluación de Efectos?

Se entiende como una Evaluación de Efectos (EE), en el marco de la Plataforma, aquella que permite ver si -y en qué grado- la intervención logró cambios efectivos en el comportamiento y características de sus beneficiarios (CEDE, 2015). Es decir, las EE buscan recolectar información y evidencia de los resultados reales del programa sobre los participantes. Este tipo de evaluación abarca diferentes metodologías y tipos de evaluación, incluyendo también estrategias cualitativas y cuantitativas. La diferencia entre una y otra corresponde al nivel de información requerida, a la representatividad de los resultados y a la confianza en el nivel de atribución que cada metodología le puede dar al programa para explicar los cambios observados.

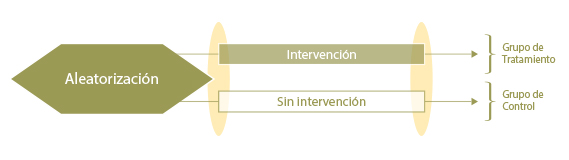

La Evaluación de Resultado (ER) y la Evaluación de Impacto por RCT (Randomized Control Trial) corresponden a dos de las metodologías de la Evaluación de Efectos que son implementadas por la Plataforma para la evaluación de los casos de Graduación. Ambos métodos se diferencian por su capacidad de definir niveles de atribución (i.e. causalidad). Una ER recolecta información en dos momentos; antes y después de la intervención, de la población participante en el programa, con el fin de cuantificar cambios en la población y tratar de relacionarlos con la implementación del programa. Las Evaluaciones de Impacto, por su parte, procuran hacer uso de características del diseño del programa o de herramientas estadísticas, para reunir información no solo de la población participante sino también de un grupo de personas que imite de la mejor forma a los hogares que son participantes pero que por alguna razón (e.g., focalización geográfica) no recibieron la intervención, lo que se conoce como el grupo de control. De esta forma, las Evaluaciones de Impacto podrían aislar el efecto causal real del programa al comparar al grupo que recibió el programa (grupo de tratamiento) y al grupo que no lo recibió (grupo de control). En particular, las evaluaciones por RCT corresponden a la metodología de impacto más robusta al “construir” el grupo de control antes de la intervención, aleatorizando quien recibe y quien no el programa.

En general, la Plataforma promueve el uso de metodologías mixtas, en el que la información cuantitativa se complementa con información cualitativa. De esta forma se pueden entender mejor los resultados cuantitativos y se tienen más elementos para la discusión sobre las implicaciones de política. Las estrategias cualitativas incluyen, entre otras, entrevistas, grupos focales y relatos autobiográficos (Historias de Vida).

¿Para qué sirve la Evaluación de Efectos?

Las Evaluaciones de Efectos son particularmente importantes para justificar la existencia de un programa y, por tanto, su continuidad en el tiempo o su escalamiento a una mayor población beneficiaria. De esta forma, las EE son de mucha utilidad a diseñadores e implementadores para sustentar la utilidad del programa y evidenciar el cumplimiento de sus objetivos. Esta información permite a su vez hacer cambios en el diseño, en caso de requerirlos, al igual que probar nuevos procedimientos y evaluar cuál es la mejor opción. De la misma forma, la información de los resultados es crucial para evaluar la sostenibilidad económica del proyecto en cuanto es uno de los insumos de las evaluaciones costo-beneficio.

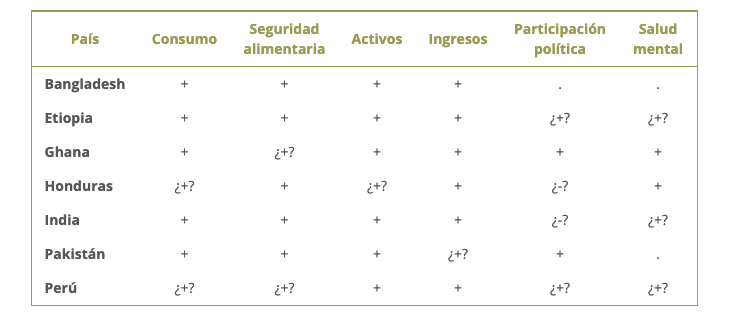

Los Programas Graduación son uno de los ejemplos claros de los resultados positivos de acompañar y apoyar la implementación de diseños novedosos con evaluaciones rigurosas que sustenten con la mayor claridad los efectos del programa. Tanto el BRAC como la Fundación Ford y el CGAP han implementado Evaluaciones de Impacto por RCT para varias de las intervenciones lideradas por ellos. Esto ha llevado a que exista prueba suficiente sobre las bondades de los Programa Graduación. Algunos de los principales resultados en cada uno de los países sobre variables claves se presentan en el siguiente cuadro:

¿+? y ¿-? hacen referencia a efectos positivos y negativos respectivamente, pero sin encontrar evidencia estadística que lo apoye.

Fuente: Banerjee et al. (2015); Bandiera et al. (2011); Briefs IPA

¿Cómo se hace la Evaluación de Efectos?

La Evaluación de Resultados contempla la recolección de información cuantitativa antes y después de la implementación, con el fin de comparar el estado de los hogares participante con y sin el programa. Los requerimientos mínimos en el diseño metodológico de una ER incluye:

1. Identificación y priorización de los resultados a evaluar

Previo a la etapa de planeación y diseño de la Evaluación de Resultados, la identificación y priorización de los resultados a ser medidos permite establecer con claridad los objetivos y el alcance de las evaluaciones que se plantean. Todos los programas con enfoque de Graduación tienen una serie de objetivos comunes por lo que se espera resultados particulares para todos los casos.

2. Construcción de los indicadores de interés

Cada resultado a evaluar, escogido durante la etapa previa, debe contar con por lo menos un indicador claro y cuantificable a partir del cual se pueda determinar si se han obtenido avances o no en esos resultados particulares. Los indicadores deben ser escogidos guiados a partir de la metodología CREMA que expone DNP (2012) y desarrollada por el Banco Mundial, en la que los indicadores deben ser:

- Claros, es decir que sean precisos e inequívocos,

- Relevantes, en cuanto sean apropiados para el resultado particular de interés,

- Económico, que sus costos de cálculo sean razonables,

- Medibles, es decir que sea susceptible de validación externa, y

- Adecuados, que ofrezcan información suficiente para estimar el desempeño.

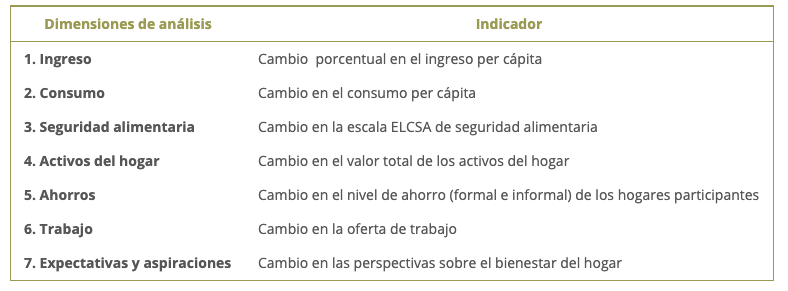

Para el caso de la Plataforma se han definido los siguientes Indicadores:

3. Fijación de las metas en términos de los indicadores

Un proceso sugerido por McNamara (2006) es el establecer, a la luz de los objetivos y resultados definidos, las metas para los indicadores propuestos. Esto es un ejercicio que se debe plantear en conjunto con las instituciones implementadoras de los programas, a partir de sus expectativas sobre el programa.

4. Diseño de las herramientas de recolección de información

El objetivo principal de este requerimiento es establecer la información que se requiere para la construcción, y estimación e interpretación de los indicadores definidos en las etapas previas. Para la evaluación de resultados se usará un enfoque complementario entre las técnicas de investigación cualitativas y cuantitativas. Este enfoque se realizará con el fin de que haya una retroalimentación entre los hallazgos de éstas dos técnicas para entender más claramente los resultados de la evaluación y los efectos sobre los participantes, así como los canales a través de los cuales éstos se hacen efectivos.

De esta forma, la adaptación de esta metodología a cada caso particular contempla especificar con claridad las actividades a realizarse dentro del análisis cuantitativo y el análisis cualitativo, y la forma en la que se espera que estos dos análisis interactúen. El análisis cuantitativo contempla la elaboración de una encuesta que se realiza antes y después de la implementación, cuyo diseño muestral se define a partir de la disponibilidad de recursos, el cambio que se quiere detectar estadísticamente en la media del grupo antes y después de la intervención, al igual que el tamaño de la intervención. El análisis cualitativo por su parte puede incluir, entre otras, grupos focales, entrevistas grupales o individuales, e historias de vida. La elección de las herramientas depende del complemento que se busca entre los dos tipos de análisis.

5. Estrategia de análisis de la información y resultados

La estrategia de ER propuesta permite hacer dos tipos de análisis a partir de la información recolectada. La primera corresponde al análisis de los indicadores, a partir de la comparación entre la línea base y la línea final. Por otro lado, el segundo tipo de análisis busca mirar cambios estructurales de los resultados a partir de diferentes variables sociodemográficas.

Evaluación de Impacto por RCT

La Evaluación de Resultados contempla la recolección de información cuantitativa antes y después de la implementación, con el fin de comparar el estado de los hogares participante con y sin el programa. Los requerimientos mínimos en el diseño metodológico de una ER incluye:

1. Identificación y priorización de los resultados a evaluar

Previo a las etapas de planeación y diseño de la evaluación de impacto, la identificación y priorización de los resultados a ser medidos permiten establecer objetivos claro y determinar el alcance de la evaluación propuesta. Por ejemplo, en el marco de la Plataforma, todos los Programas Graduación tienen ciertos logros comunes por lo que se esperan efectos particulares, como la reducción de la pobreza, el incremento de la seguridad alimentaria de los hogares, creación de fuentes de auto empleo, incremento de los niveles de ahorro, creación de habilidades sociales y para la vida, y crecimiento personal (De Montesquiou et al, 2014. Banerjee et al, 2015.). Aun así, el proceso de contextualización de los Programas Graduación podría requerir otras variables. Aclarar qué resultados son de interés y de utilidad para los implementadores y los evaluadores es necesario antes de avanzar en el diseño de la evaluación.

2. Estrategia de aleatorización

El reto de un RCT es tener un grupo de control que sea en promedio lo más parecido posible al grupo de tratamiento, y una de las formas de lograrlo es a través de la aleatorización. Por esto, la aleatorización es parte fundamental de un RCT. La literatura sugiere diferentes tipos de estrategias que permiten obtener un diseño eficiente, según el contexto particular, sin sacrificar la robustez de este tipo de evaluación. Hay al menos tres elementos de un programa que se pueden aleatorizar: acceso, temporalidad e invitación a participar, tanto a nivel individual como grupal (Glennerster y Takavarasha, 2013). Como lo sugieren Glennerster y Takavarasha (2013) y Bernal y Peña (2011), la selección de una estrategia de aleatorización dependerá del contexto y las limitaciones particulares de la evaluación propuesta. Cada una de las estrategias tendrá implicaciones prácticas, políticas, metodológicas y éticas.

3. Cálculos de poder y diseño muestral

El poder de un diseño de RCT corresponde a la habilidad que tiene este para identificar como estadísticamente significativos (a un nivel de confianza α dado) los efectos percibidos. Es decir, es la habilidad de identificar que el aumento o la reducción de una de las variables de resultado, cuando se compara la información de los tratados y los controles, no es por azar, sino que estos resultados se presentarían en la generalidad de los casos en los que se implemente el programa evaluado.

El poder depende críticamente de (1) la estrategia de aleatorización, (2) del número de hogares tratados, (3) del número de hogares encuestados, (4) del nivel de confianza estadística que se desean para los resultados y (5) de la periodicidad de las encuestas. Por esto, los análisis de poder determinan también el diseño muestral con el que se recogería la información cuantitativa.

4. Diseño de las herramientas de recolección de información

Se sugiere que los RCT complementen sus técnicas cuantitativas (encuesta) con estrategias de investigación cualitativa. Esta aproximación permite que los resultados de cada técnica se retroalimenten para así tener resultados más completos y relevantes para la política pública. Esto permite también mayor claridad en el entendimiento de la evaluación y de los efectos en los participantes, al igual que de los canales por los que estos se hacen efectivos.

5. Estrategia de monitoreo

Las evaluaciones de impacto por RCT requieren del diseño y desarrollo de protocolos de seguimiento y aleatorización. Parte de la validez de los resultados de este tipo de ejercicios depende de que los hogares/participantes definidos como tratados reciben efectivamente el programa, mientras que los hogares/participantes que fueron asignados a los controles no lo reciban. De la misma forma se debe mantener un seguimiento continuo a otras intervenciones existentes diferentes a la evaluada.

Referencias

Centro de Estudios sobre Desarrollo Económico – CEDE (2015). Metodología para la Evaluación de Resultados. Documento Interno de Trabajo. Plataforma de Evaluación y Aprendizaje de los Programas de Graduación en América Latina. CEDE – Facultad de Economía, Universidad de los Andes.

Banerjee, A., E. Duflo, N. Goldberg, D. Karlan, R. Osei, W.Pariente, J. Shapiro, B. Thuysbaert, and C. Udry (2015). “A Multifaceted Program Causes Lasting Progress for the Very Poor: Evidence from Six Countries.” Science 348, no. 6236 (May 14, 2015).

Bandiera O., Burguess R., Das N., Gulesci S., Rasul I. Shams R. y Sulaiman M. (2011). “Asset Transfer Programme for the Ultra Poor: A Randomized Control Trial Evaluation”. CFPR Working Paper 22. Disponible en: https://www.microfinancegateway.org/sites/default/files/publication_files/asset_transfer_programme_for_the_ultra_poor-_a_randomized_control_trial_evaluation.pdf

Departamento Nacional de Planeación – DNP (2012). Guias Metodológicas Sinergia – Guía para la Evaluación de Políticas Públicas. Bogotá D.C., Colombia.

McNamara, Carter (2006). Basic Guide to Program Evaluation. Disponible en: managementhelp.org/evaluation/program-evaluation-guide.htm

De Montesquiou, A., Sheldon, T., De Giovanni, F,. and Hashemi, S. (2014). From Extreme Poverty to Sustainable Livelihoods: A Technical Guide to the Graduation Approach. Consultative Group to Assist the Poor (CGAP) and BRAC Development Institute.

Glennerster, R., & Takavarasha, K. (2013). Running randomized evaluations: A practical guide. Princeton University Press.

Bernal, R., y Peña, X. (2011). Guía práctica para la evaluación de impacto. Universidad de los Andes, Facultad de Economía, Centro de Estudios sobre Desarrollo Económico.

¿Qué son las Historias de Vida?

La Historia de Vida (HV) es una técnica de investigación cualitativa, que hace parte del método biográfico (Sanz, 2005), con la cual se construye un relato de la historia que realiza un informante sobre su propia vida, en conjunto con la recopilación y análisis de información adicional del contexto, proveniente, por ejemplo, de registros documentales y de entrevistas a personas del entorno social del entrevistado. Para el caso de interés, el informante es el participante seleccionado del programa a evaluar.

La incorporación de las historias de vida en la Plataforma, tiene el propósito de entender las actitudes y los comportamientos actuales de los participantes del programa bajo evaluación, y la manera cómo actitudes y comportamientos son influenciadas por la intervención.

Las HV son de carácter individual, por lo que se basa principalmente en entrevistas privadas con los participantes que deciden participar en este ejercicio. El interés de la Plataforma es desarrollar relatos autobiográficos múltiples recogiendo así los relatos de varios participantes en el programa en un periodo de tiempo definido. El número de HV se define según el caso particular, dependiendo de la variabilidad de la población focalizada con el programa a evaluar. De la misma forma, las entrevistas individuales de los hogares bajo seguimiento son complementadas con entrevistas a funcionarios del programa o a otros hogares, con el fin de complementar la perspectiva del participante.

¿Para qué sirven las Historias de Vida?

La información de tipo cualitativo que se recoge a partir de las historias de vida es de gran utilidad para diseñadores e implementadores de programas, porque, por un lado, ofrece señales sobre la percepción que tienen los participantes acerca de los procesos y actividades del programa evaluado y, por otro, permite identificar los cambios que el programa ha producido en los hogares, así como entender los mecanismos o canales a través de los cuales se han generado esos cambios. Es una herramienta particularmente útil cuando se busca entender los efectos del programa sobre variables que son de compleja medición, tales como aquellas relativas a bienestar, empoderamiento, aspiraciones y expectativas, uso del tiempo, entre otras.

De esta forma, las historias de vida, constituyen un complemento fundamental de las evaluaciones de efectos, porque permiten entender los resultados cuantitativos de estas evaluaciones y facilitan la comprensión de cambios en variables complejas; así se ha demostrado con el uso de esta metodología en evaluaciones previas de los programas graduación en Etiopia – Ethiopia Graduation Pilot- (Sengupta, 2012), Paquistán – Pakistan Graduation Pilot- (Kabeer, Huda, Kaur y Lamhauge, 2011) e India -Trickle Up Ultra Poor Program- (Huda y Kaur, 2011; Sengupta, 2012; Kabeer, Huda, Kaur y Lamhauge, 2011).

¿Cómo se hacen las Historias de Vida?

El diseño metodológico de las Historias de Vida contempla 3 elementos principales. Estos son:

Definición de la población objetivo

La población objetivo de las Historias de Vida corresponde a participantes del programa a evaluar. Como en otras metodologías cualitativas, las Historias de Vida procuran por ahondar en el análisis de pocos individuos para ganar profundidad en su análisis; por esta razón, es importante definir ciertos criterios de selección aportando así la mayor variabilidad en los sujetos de estudio.

Si bien los criterios de selección dependen de cada caso, algunas posibles consideraciones son:

- Representación geográfica.

- Composiciones del hogar diferentes.

- Diferente nivel de aislamiento de mercado de relevancia.

- Diferentes condiciones de acceso al programa evaluado (e.j. vulnerabilidad por pobreza o victimas de conflicto, entre otros).

Definición de los periodos de recolección

La construcción de las Historias de Vida Truncadas se realiza a partir de visitas periódicas a los hogares participantes durante toda la implementación del programa. Las fechas de las visitas se ajustarán con el desarrollo del Programa de Graduación en momentos claves de su implementación.

Con el propósito de generar el entorno propicio para la entrevista y buscar la comodidad y tranquilidad del entrevistado, las visitas se llevarán a cabo en los momentos, lugares y situaciones que prefiera el entrevistado.

Recolección de información

Información primaria

La información primaria proviene principalmente de las entrevistas a los participantes. Es importante aclarar que la participación de los hogares en este ejercicio debe ser enteramente voluntaria, y que esta aprobación debe ser respaldada por medio de un consentimiento escrito de los hogares participantes.

Cada una de las entrevistas deben mantener un objetivo claro, el cual guíe cada una de las visitas. Se sugiere desarrollar una primera visita con fines exploratorios y que el resto de las visitas se desarrollen dependiendo de (1) los requerimientos de información particulares de cada evaluación y (2) el desarrollo del programa.

La Plataforma promueve que el seguimiento a los hogares seleccionados (los “hogares focales”) se desarrolle en conjunto con entrevistas adicionales a otros hogares en la misma comunidad (“hogares satélites”), y que por lo mismo reciban de forma parecida el programa. Así mismo, es pertinente el desarrollo de entrevistas a funcionarios, cercanos a los hogares en la implementación. En el caso de los Programas Graduación esto podría equivaler a hogares que estuvieran asignados al mismo gestor. Estas entrevistas adicionales permiten triangular información para comprender mejor los cambios que se generan -o no- en los hogares participantes de las Historias de Vida, así como su contexto o ‘ventana’ de oportunidades (Moreno-Sánchez et al., 2017).

Información secundaria

Antes -y durante- las visitas exploratorias se busca realizar una revisión bibliográfica de información secundaria para los municipios/localidades donde se llevarán a cabo las historias de vida. Las principales fuentes de información incluyen la entidad encargada de producir las estadísticas nacionales, bibliotecas, entidades municipales de asistencia técnica, alcaldía municipal, gobernación (planes de ordenamiento territorial, planes de desarrollo municipales, diagnósticos agropecuarios, etc.). El objetivo de la recolección de información secundaria es conocer y entender el contexto general de los municipios/localidades donde se aplicarán las historias de vida, contexto que puede afectar de manera diferencial las experiencias de los hogares con el programa.

Referencias

Huda, K and Kaur, S. 2011. ‘‘It was as if we were drowning’’: shocks, stresses and safety nets in India, Gender & Development, 19:2, 213-227

Kabeer, N., Huda, K., Kaur, S., and Lamhauge, N. 2011. “And Who Listens to the Poor?” Shocks, stresses and safety nets in India and Pakistan. BRAC Development Institute. Disponible en: http://www.merit.unu.edu/events/event-abstract/?id=986

Lybbert, T. and Wydick, B. (2016). “Poverty, Aspirations, and the Economics of Hope”. Economic Development and Cultural Change.

Ray, D. (2002). Aspirations, Poverty and Economic Change. New York University and Instituto de Análisis Económico (CSIC). URL: https://www.nyu.edu/econ/user/debraj/Courses/Readings/povasp01.pdf.

Sanz, A. 2005. El método biográfico en investigación social: Potencialidades y limitaciones de las fuentes orales y los documentos personales. Asclepio. Vol. 57, No 1. Disponible en: http://www.eduneg.net/generaciondeteoria/files/SANZ-2005-El-metodo-biografico-en-la-invest-social.pdf

Sengupta, A. 2012 (a). Pathways out of the Productive Safety Net Programme: Lessons from Graduation Pilot in Ethiopia. Working Paper. The Master Card Fundation and BRAC Development Institute. Disponible: http://www.microfinancegateway.org/sites/default/files/publication_files/pathway-out-of-psnp.pdf

Sengupta, A. 2012. Trickle up – Ultra Poor Programme. Qualitative Assessment of Sustainability of Programme Outcomes. The Master Card Fundation and BRAC Development Institute. Disponible en: http://www.microfinancegateway.org/sites/default/files/publication_files/trickle-up-up-program-final-qualitative-assessment.pdf

Moreno-Sánchez, R., Rodriguez C.A., Martinez, V., y Maldonado J. 2017. Historias de Vida-PxMF. Reporte Final. Parte I: Introducción. Documento Interno de Trabajo. Plataforma de Evaluación y Aprendizaje de los Programas de Graduación en América Latina. CEDE-Facultad de Economía, Universidad de los Andes.

Con el

apoyo de: